近几年,大数据的概念逐渐深入人心,大数据的趋势越来越火爆。但是,大数据到底是个啥?怎么样才能玩好大数据呢?

大数据的基本含义就是海量数据,麦肯锡全球研究所给出的定义是:一种规模大到在获取、存储、管理、分析方面大大超出了传统数据库软件工具能力范围的数据集合,具有海量的数据规模、快速的数据流转、多样的数据类型和价值密度低四大特征。

数字经济的要素之一就是大数据资源,现在大家聊得最多的大数据是基于已经存在的大数据的应用开发。

如今,大数据技术已应用在各行各业。小麦举个例子,讲述一下最贴近我们生活的民生服务是如何运用大数据。

最近电视新闻提及到的“一网统管”精准救助场景,传统的救助方式往往通过困难家庭申请、审核、审批等多项程序,遇到需要跨部门、跨层级、跨街区协调解决的个案,还需要召开各级协调会的形式协商解决。

现在通过“精准救助”的方式,民政部门在平时的摸排中了解情况,将相关信息录入到“一网统管”数据中心,再根据数据模型识别出需要协助的家庭,随后形成走访工单派发给社工对其进行帮扶,从而提升救助的效率,做到雪中送炭。

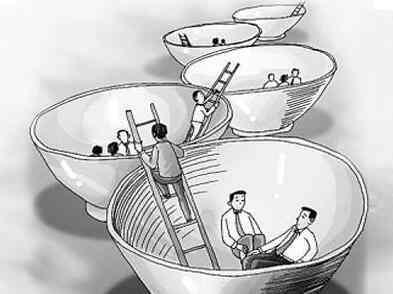

在数字化政府改造之前,每个部门只掌握各自分管的数据,形成“信息孤岛”;有了大数据分析平台后,所有的数据信息,便打通了“任督二脉”。

政府可以充分利用大数据技术打造“一网统管”精准救助场景,极大提升了社会救助的科学性和精准性,让城市变得更加温暖。

就以悟空问答为例说说大数据的故事。以下说的数字都不是真实的,都是我的假设。

比如每天都有1亿的用户在悟空问答上回答问题或者阅读问答。

每天产生的内容假设平均有1000万的用户每天回答一个问题。一个问题平均有1000的字, 平均一个汉字占2个字节byte,三张图片, 平均一帐图片300KB。那么一天的数据量就是:

为了收集用户行为,所有的进出悟空问答页面的用户。点击,查询,停留,点赞,转发,收藏都会产生一条记录存储下来。这个量级更大。

所以粗略估计一天20TB的数据量. 一般的PC电脑配置大概1TB,一天就需要20台PC的存储。

如果一个月的,一年的数据可以算一下有多少。传统的数据库系统在量上就很难做到。

另外这些数据都是文档类型的数据。需要各种不同的存储系统支持,比如NoSQL数据库。

需要分布式数据存储,比如Hadoop的HDFS。

数据的流动上述1000万个答案,会有1亿的人阅读。提供服务的系统成百上千。这些数据需要在网上各个系统间来回传播。需要消息系统比如Kafka。

在线用户量同时在线的用户量在高峰时可能达到几千万。如此高的访问量需要数前台服务器同时提供一致的服务。为了给用户提供秒级的服务体现,需要加缓存系统比如redis。

机器学习,智能推荐所有的内容包括图片都会还用来机器学习的分析,从而得到每个用户的喜好,给用户推荐合适的内容和广告。还有如此大量的数据,必须实时的分析,审核,审核通过才能发布,人工审核肯定做不到,必须利用机器来智能分析,需要模式识别,机器学习,深度学习。实时计算需要Spark,Flink等流式计算技术。

服务器的管理几千台服务器,协同工作。网络和硬件会经常出问题。这么多的资源能够得到有效利用需要利用云计算技术,K8S等容器管理工具。还需要分布式系统的可靠性和容灾技术。